Computación neuromórfica

La computación neuromórfica (CN) es un paradigma informático que busca replicar la estructura y función del cerebro humano. Esta tecnología promete superar las limitaciones de la computación digital clásica (basada en arquitecturas Von Neumann y GPUs) en términos de eficiencia energética, velocidad y capacidad de adaptación para la inteligencia artificial (IA).

A continuación, se presenta un resumen estructurado y detallado que compara ambos modelos de computación y expone los aspectos técnicos, históricos y comerciales de la CN, basados en el análisis de las fuentes.

1. Comparación Detallada: Computación Clásica (CC) vs. Computación Neuromórfica (CN)

La CC se asemeja a una «máquina» que procesa información de manera generalmente secuencial, mientras que la CN imita la biología, procesando la información en paralelo.

| Aspecto | Computación Clásica (Digital/GPUs) | Computación Neuromórfica (CN) |

|---|---|---|

| Arquitectura | Arquitectura Von Neumann (separación de CPU/GPU y memoria). | Arquitectura inspirada en el cerebro, donde el procesamiento y el almacenamiento están integrados en la misma ubicación física. Redes recurrentes e irregulares. |

| Procesamiento | Sincrónico, basado en bits (ceros y unos). Vectorizado, con multiplicación de matrices densas. | Asíncrono, basado en picos o impulsos (spikes). Procesamiento en paralelo y basado en eventos (event-driven). |

| Eficiencia Energética | Altamente ineficiente. Consume energía constantemente, incluso inactivo. Una GPU H100 puede consumir 35 veces más energía que el cerebro humano (TDP de 700 W). | Ultra bajo consumo. Solo consume energía cuando se produce un pico (basado en eventos). El cerebro humano usa solo 20 W en máximo rendimiento. |

| Velocidad/Latencia | Limitada por el cuello de botella de la memoria (tiempo y energía gastados en acceder a los pesos). Lenta para tareas en tiempo real. | Inmensamente rápido y con gran capacidad de respuesta. Procesamiento en tiempo real para datos sensoriales. |

| Datos | Eficiente en el manejo de grandes cantidades de datos uniformes (cálculos densos). | Ideal para cómputos dispersos (datos con muchos ceros). Solo activa las vías neuronales afectadas por los cambios. |

| Programación | Basada en instrucciones programadas rígidamente. | Requiere una mentalidad de programación completamente diferente. La computación es un resultado emergente del sistema dinámico. |

| Desafíos | Límites de miniaturización (Ley de Moore). Falta de memoria para modelos grandes. Generación de carbono y calor. | Dificultad de programación y falta de herramientas estandarizadas. |

2. Beneficios Principales y Diferencias Clave

El mayor beneficio de la computación neuromórfica es su eficiencia energética extrema combinada con su capacidad de procesamiento y toma de decisiones en tiempo real.

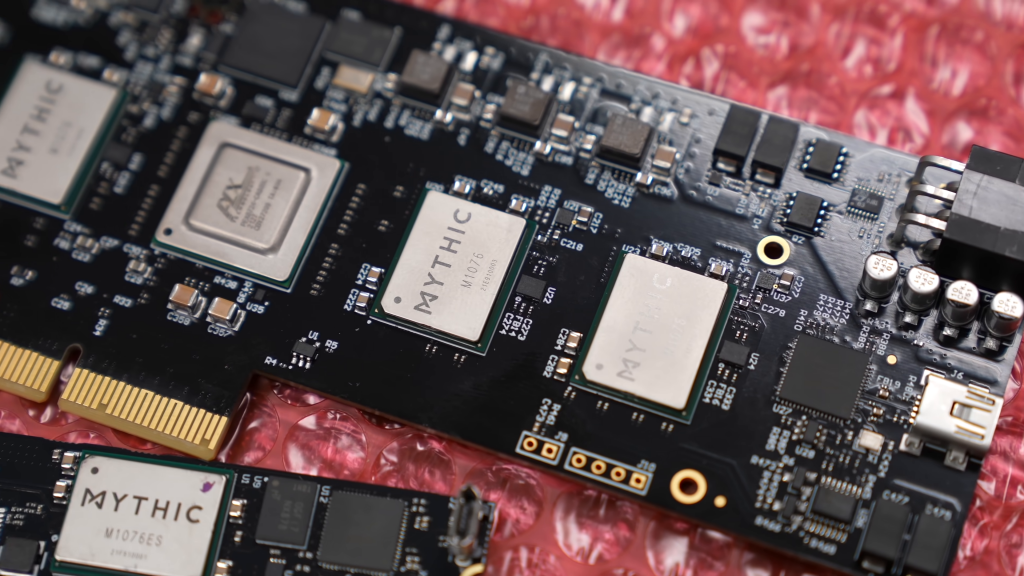

La CN solo consume energía cuando procesa un pico, lo que resulta en un consumo ultra bajo en comparación con los ordenadores tradicionales. Por ejemplo, un chip neuromórfico (Mythic AI) puede alcanzar 25 billones de operaciones por segundo (TOPS) consumiendo solo 3 W de energía, mientras que los sistemas digitales que ofrecen un rendimiento similar (25 a 100 TOPS) son sistemas grandes que consumen de 50 a 100 W.

Las diferencias clave con la computación clásica se centran en la arquitectura y la comunicación:

- Paralelismo y Asincronía: La CN procesa la información en paralelo, sin un reloj central que controle todo (funcionamiento asíncrono, basado en eventos). La CC opera de manera secuencial o vectorizada.

- Unidades de Información: La CN utiliza picos o impulsos (spikes), que son eventos binarios donde la información está codificada por el tiempo en que se disparan, en lugar de utilizar bits (unos o ceros) como en la CC.

- Integración de Memoria: La CN elimina el «cuello de botella de Von Neumann» al integrar el procesamiento y el almacenamiento de datos en la misma ubicación física, dentro de cada neurona artificial, al igual que el cerebro.

3. Contexto Histórico de la Computación Neuromórfica

La historia de la CN comienza formalmente en la década de 1980 con el ingeniero visionario Carver Mid, quien acuñó el término «neuromórfico». Mid fue pionero en la idea de construir circuitos electrónicos que imitaran el sistema nervioso humano, buscando cerrar la brecha entre la biología y la tecnología.

Aunque el término es de los 80, la inspiración del cerebro ha estado presente desde los orígenes de la computación moderna. Alan Turing se preguntó en 1950 si las máquinas podían pensar, y los pioneros como Von Neumann y Turing tuvieron el cerebro en mente al desarrollar las nociones arquitectónicas originales de la computación.

Un precursor clave fue el Perceptrón, construido en 1958 por el psicólogo Frank Rosenblad para imitar a las neuronas. Los avances continuos en la neurociencia y la tecnología de semiconductores han allanado el camino para el desarrollo de chips neuromórficos cada vez más sofisticados.

4. Desarrollos Recientes y Resultados Específicos

Investigadores y empresas han desarrollado chips que ejemplifican el potencial de la CN:

- Intel Loihi: Esta primera generación cuenta con más de 130,000 neuronas y 130 millones de sinapsis.

- IBM True North: Diseñado para una eficiencia energética extrema, este chip alberga 1 millón de neuronas y 256 millones de sinapsis, consumiendo solo unos pocos vatios de potencia. Está compuesto por 4096 núcleos neurosinápticos organizados en una cuadrícula de 64×64.

- Intel Loihi 2: Implementado en un proceso CMOS estándar y totalmente digital. En el dominio de la optimización, Loihi ha demostrado ser capaz de resolver problemas complejos como la programación ferroviaria y problemas de Cubo (provenientes de la computación cuántica) con ganancias de magnitud en comparación con los mejores solucionadores convencionales.

- Sandia National Laboratories: Desarrolló un sistema con capacidad de simular 180 millones de neuronas, replicando las propiedades físicas y estructuras del sistema nervioso.

5. Actores Industriales

El campo de la CN está siendo impulsado por grandes corporaciones y startups especializadas:

- Intel (Chip Loihi, Loihi 2).

- IBM (Chip True North).

- BrainChip (Chip Akida), optimizado para IA en el «borde» (edge AI).

- SpiNNaker (Arquitectura de red neuronal de picos).

- Prophesee, que desarrolla sensores y sistemas de visión neuromórfica (cámaras basadas en eventos) que imitan el ojo humano.

- InSense e Innatera, que trabajan en procesadores neuromórficos de ultra bajo consumo para dispositivos del Internet de las Cosas (IoT) y dispositivos portátiles (wearables).

- Reina, respaldada por Sam Altman, que busca reducir significativamente el consumo de energía combinando procesamiento y memoria.

- Cognifiber, que adopta un enfoque único al desarrollar procesadores neuromórficos completamente ópticos o fotónicos, utilizando la luz para la computación para aumentar significativamente la velocidad y la eficiencia energética.

6. Fundamentos Técnicos de la Computación Neuromórfica

La CN se basa en replicar la red de neuronas y sinapsis artificiales.

Funcionamiento Básico:

- Componentes: El núcleo de un chip neuromórfico contiene una matriz de neuronas artificiales (unidades de procesamiento) y sinapsis artificiales (que gobiernan el flujo de señal).

- Procesamiento de Impulsos: Las neuronas se comunican mediante picos o impulsos eléctricos (spikes). Un pico se genera cuando la entrada sináptica acumulada en la neurona supera un umbral.

- Comunicación Asíncrona: En lugar de enviar datos a través de un bus, utilizan un protocolo llamado Representación de Eventos de Dirección (AER), que permite a las neuronas comunicarse directamente enviando picos que actúan como direcciones.

- Núcleos Neuromórficos: Los procesadores consisten en múltiples núcleos neuronales interconectados, cada uno con su propia matriz de neuronas y sinapsis. Los núcleos en Loihi 2, por ejemplo, contienen un pipeline de procesamiento de señales asíncrono y mucha memoria interna.

- Aprendizaje: El aprendizaje se logra ajustando la fuerza de las conexiones sinápticas con el tiempo. Los mecanismos incluyen el Aprendizaje Hebbiano (fortalecimiento de las conexiones cuando las neuronas disparan juntas) y la Plasticidad Dependiente del Tiempo de los Impulsos (PDTI).

7. Rendimiento Comparativo (Velocidad y Consumo Específicos)

La superioridad de la CN se manifiesta en su rendimiento por vatio.

Mientras que los sistemas digitales más nuevos pueden alcanzar de 25 a 100 billones de operaciones por segundo (TOPS) utilizando grandes sistemas que consumen de 50 a 100 W de potencia, un chip neuromórfico analógico de Mythic AI puede realizar 25 billones de operaciones matemáticas por segundo consumiendo tan solo 3 W de energía.

Esto demuestra que, aunque los circuitos CMOS digitales operan a nanosegundos y gigahercios (mucho más rápido que los milisegundos y kilohercios de la biología), la CN aprovecha la comunicación dispersa y asíncrona para lograr una eficiencia y velocidad comparables con una fracción del consumo de energía del hardware tradicional de IA.

El contraste es más dramático con las GPUs de alta gama, como la H100, que tienen un TDP de hasta 700 W y cuyo entrenamiento de modelos grandes (ej., GPT-4) consume cantidades masivas de energía (aproximadamente 41,000 MWh).

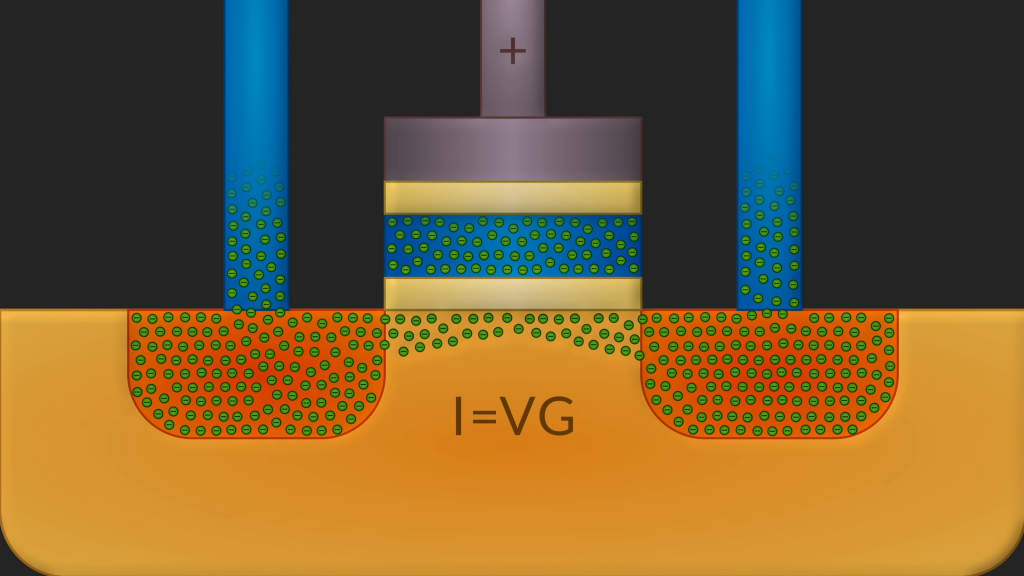

8. Explicación Técnica Detallada: Memresistores

El memristor (una contracción de memoria y resistencia) es un candidato prometedor para las arquitecturas neuromórficas.

Función y Estructura:

Los memristores son pequeños interruptores que tienen memoria y combinan las funciones de resistencia y memoria en un único componente. En los chips neuromórficos, actúan como las conexiones o sinapsis entre las neuronas artificiales. Un memristor está típicamente hecho de una capa delgada de óxido metálico (como el óxido de titanio) ubicada entre dos piezas de metal.

Mecanismo de Cambio de Resistencia (Plasticidad Sináptica):

Cuando se aplica electricidad, pequeñas partículas en la capa de óxido se mueven, lo que cambia la resistencia (cómo fluye la electricidad a través de la capa). Este cambio persiste incluso después de que se apaga la energía, actuando como un regulador de luz que recuerda su configuración. Esta capacidad de cambiar y conservar su estado (su fuerza) es similar a cómo las sinapsis en el cerebro se fortalecen o debilitan (el proceso de aprendizaje y olvido).

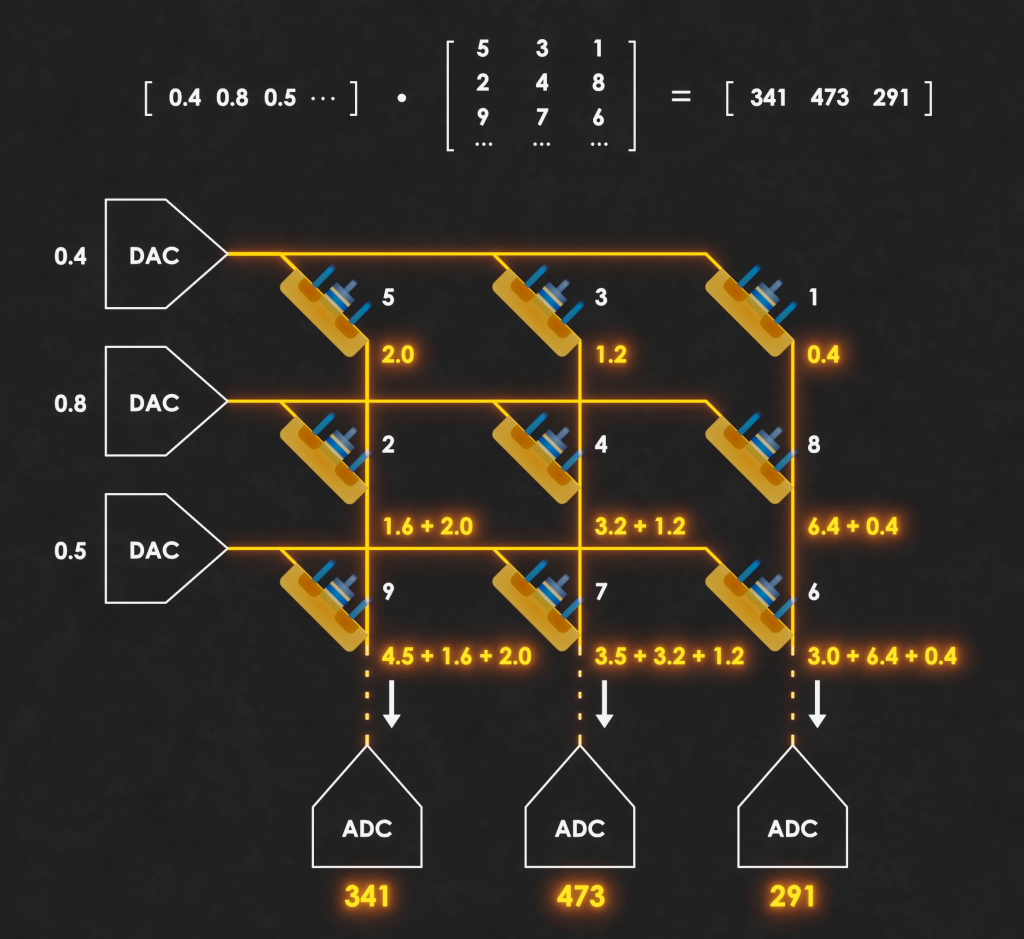

Papel en la Computación Analógica y Almacenamiento de Pesos:

Los memristores pueden utilizarse para almacenar y procesar información en el mismo lugar. En el contexto de las redes neuronales artificiales, la conductancia (la inversa de la resistencia) de cada memristor puede utilizarse para inscribir los pesos de la red.

La multiplicación matricial, central en las redes neuronales, se realiza de manera eficiente utilizando el memristor:

- Se inscriben los pesos de la red como la conductancia de las celdas.

- Los valores de activación se ingresan como el voltaje aplicado a las celdas.

- La corriente resultante que fluye a través del memristor es el producto de voltaje por conductancia (Ley de Ohm: I = V/R, o I = V * G, donde G es la conductancia), lo que simula la operación de activación por peso.

Al conectar las celdas de manera que las corrientes se sumen, se completa la multiplicación de matrices necesaria para la propagación de la señal en la red.